1月27日,Google宣布由其子公司DeepMind开发的人工智能AlphaGo在五场比赛中击败了欧洲围棋冠军范慧。

您可能听说过以下消息:它在世界范围内成为头条新闻,但是为什么人们这么在乎呢?这是什么意思呢?如果您不熟悉Go的游戏或其对人工智能的重要性,那么您可能会感到有些迷茫。

别担心,我们为您提供了帮助。这是您需要了解的有关突破以及它如何影响像您和我这样的普通人的所有信息。

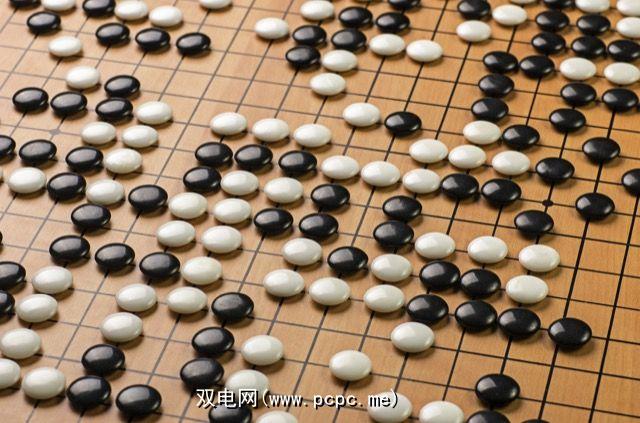

围棋游戏:既简单又复杂

围棋是中国古代的战略游戏,其中两名玩家争夺领土。依次轮流,每个玩家-一个白人,另一个黑人-在19 x 19网格的交点上放置石头。当一组石头完全被其他玩家的石头包围时,它们将被“捕获"并从棋盘上移走。

在游戏结束时,每个空白点都由玩家“拥有"围绕它。每个玩家的得分取决于他拥有多少领土(即他周围有多少空白空间)以及在比赛中被俘获的对手棋子的数量。

大多数人可能认为国际象棋是策略游戏之王,围棋实际上更复杂。根据Wikipedia的说法,围棋有10 761 个可能的游戏,而国际象棋估计有10 120 个可能的游戏。

这种复杂性以及一些深奥的规则和对本能游戏的重视使Go成为计算机在高水平学习和玩游戏时特别困难的游戏。

令人难以置信的游戏AI世界

宏大的计划,设计一个可以玩游戏的人工智能似乎并不是一个很值得的追求,特别是当IBM的Watson AI已经在致力于改善医疗保健领域时,这是一个需要所有帮助的领域。那么,为什么Google要花那么多时间和金钱来创建Go-play的AI?

On one level, it helps AI researchers figure out the best way to teach computers to do things. If you can teach a computer to solve how to find the best moves in a game of Checkers or Tic-Tac-Toe, you could gain insight into teaching a different computer how to recommend movies on Netflix , instantly translate speech, or predict earthquakes.

到目前为止,我们已经看到许多AI的用途将从改进的问题解决和模式提取中受益

Deep Blue是国际象棋冠军AI,它使用大量的计算能力和蛮力技术来评估所有可能的下一步行动—每秒高达200,000,000个职位。尽管这种策略足以击败前世界象棋冠军,但并不是一种特别的类似于人的下棋方式。

最近,开发了一个名为 deep learning 的过程,该过程从本质上为计算机完成了铺平道路。自学,这完全改变了人工智能的竞争。

通过深度学习,计算机可以从数据中提取有用的模式,而无需程序员告诉它应该寻找哪种模式,然后使用这些模式优化自己的决定。如果深度学习成功,那么AI甚至可以发现比我们认为的人类更有效的模式。

这种学习是在去年被谷歌拥有的AI研究公司DeepMind揭示的。在仅获得原始输入后,自学了49种不同的Atari游戏的AI。 (您可以在上面学习如何玩Breakout看到它。)

The process is the same as learning a video game without a tutorial or explanation. You watch for a while, then try pushing random buttons, then start to figure things out, develop strategies, and eventually go on to excel.

它表现出色。 DeepMind AI在诸如Video Pinball之类的某些游戏中彻底摧毁了专业级的人类对手。在包括《吃豆人》在内的其他游戏中,它的表现要差得多,但总体表现却非常出色。

AlphaGo:AI的新高度

AlphaGo,击败了计算机Go的Fan Hui使用了这种深度学习策略,在五场比赛中不败。

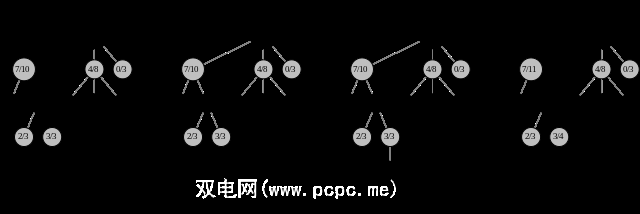

AlphaGo并没有采用像Deep Blue这样的强力计算方法,而是通过使用在训练中学到的方法来确定下一步行动来限制潜在有效动作的范围,然后运行模拟以查看哪些动作最有可能产生积极的结果。

两个不同的神经网络,即政策网络和价值网络,共同评估动作并选择

由于Go的复杂性,不可能像在国际象棋中那样对所有可能的动作采用强力方法。所以AlphaGo吸引了在训练阶段获得的知识,包括观看人类专家进行的3000万步动作,

使用强化学习,其决策过程得到了发展和强化,直到AlphaGo成为最佳的Go-play AI为止。

在世界上。在与最先进的Go电脑对战的500场比赛中,它甚至赢得了499场比赛-即使在为这些程序提供了四步领先之后也是如此。

当然,AlphaGo击败了目前的欧洲Go冠军范晖。这场胜利实际上是在2015年10月取得的,但公告的发布时间与DeepMind在 Nature 中发表的研究论文相吻合。 3月,AlphaGo将接替过去十年中全球最主要的球员Lee Sedol。

好吧,这意味着什么?

这是为什么呢?成为世界各地的头条新闻?出于种种原因,实际上。

首先,许多人认为使用当前技术是不可能的。大多数估计都认为,人工智能在以下方面不能击败世界一流的围棋选手:至少再十年。 AlphaGo的价值网络可以评估当前正在玩的任何Go游戏,并预测最终的获胜者。Google表示这个问题“实在令人难以置信,不可能。"

这表明当前的人工智能可以收集数据,提取模式,学习预测这种模式,并最终开发出足够复杂和有效的解决问题的策略,以胜过挑战。

尽管在Go上获胜并不会改变世界,但计算机能够使用自己的学习算法提出这一策略水平的事实令人印象深刻。

正是这种深度学习使AI研究人员对AlphaGo感到非常兴奋。许多人认为,独立学习是实现 strong AI 的第一步。强大的AI是指可以解决与人类同等的智力任务的计算机(这是非常困难的,主要是由于人脑的复杂性和效率)。这是您在许多科幻电影中看到的那种AI。

正因为如此,创建能够像人类一样行为的AI实在是一件大事。提取模式和制定策略是我们一直以来的工作,并且在制定决策时不会使用暴力手段。

在没有大量指导的情况下,很难让计算机做到这一点,但是由于有了AlphaGo,我们现在才知道强大的AI不仅是可行的,而且比我们想像的还要近。

当然,围棋AI距离一般的智能AI还有很长的路要走。它只做一件事,就像人工智能可以做到的那样简单-即使玩Atari的AI能够玩49种不同的游戏-但AlphaGo的有效独立学习可能是迈向AI重大范式转变的第一步。

您如何看待?

毫无疑问,AlphaGo击败樊慧很重要,但是是否值得在全球头条新闻进行辩论。

您认为这很重要吗?我们距离机器人启示录更近了一步吗?还是您对可以玩游戏的AI印象深刻?

标签: