人工智能和机器学习带来了我们今天在技术行业中看到的许多进步。但是,如何赋予机器学习能力呢?此外,我们这样做的方式如何导致意想不到的后果?

这是我们的机器学习算法快速解释器,以及一些机器学习示例出现问题的地方。

什么?机器学习是机器学习算法吗?

机器学习是计算机科学的一个分支,其重点是赋予AI学习任务的能力。这包括开发能力而无需程序员明确编写AI来完成这些事情。相反,AI可以使用数据进行自我教学。

程序员可以通过机器学习算法来实现这一点。这些算法是AI学习行为所基于的模型。算法与训练数据集结合使AI能够学习。

算法通常提供AI可以用来解决问题的模型。例如,学习如何识别猫和狗的图片。 AI将算法设定的模型应用于包含猫和狗图像的数据集。随着时间的流逝,人工智能将学习如何在没有人工干预的情况下更准确,更轻松地从狗中识别猫。

机器学习改善了诸如搜索引擎,智能家居设备,在线服务和自动机器等技术。这是Netflix知道您更喜欢看哪部电影的方式,以及音乐流服务如何推荐播放列表的方式。

但是,尽管机器学习可以使我们的生活变得更加轻松,但也会带来一些意想不到的后果。

机器学习错误的7次

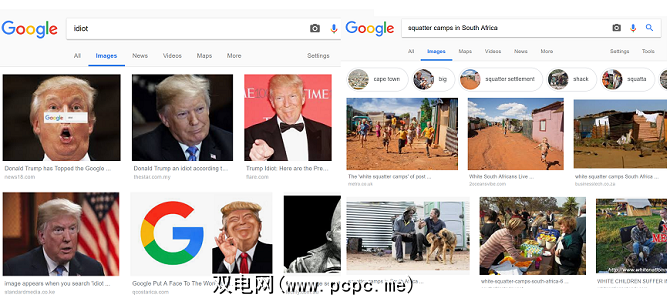

Google搜索使浏览网页变得更加容易。该引擎的算法在计算结果时会考虑多种因素,例如关键字和跳出率。但是该算法还从用户流量中学习,这可能会导致搜索结果质量出现问题。

在图像结果中,这没有什么比这更明显的了。由于访问量较高的网页更有可能显示其图片,因此通常会优先吸引吸引大量用户(包括点击诱饵)的故事。

例如,“南方的棚户区"的图片搜索结果“非洲"一词引起争议,因为它被发现主要是白人南非人。尽管有统计数据表明,住在非正式住房中的绝大多数人(例如棚屋)是南非黑人。

Google算法中使用的因素还意味着互联网用户可以操纵结果。例如,用户发起的一项运动对Google图像搜索结果的影响程度达到某种程度,即搜索“白痴"一词会显示美国总统唐纳德·特朗普的图像。

信任Twitter破坏了善意的机器学习聊天机器人。这就是在微软现在臭名昭著的聊天机器人Tay发布的一天之内发生的事情。

Tay模仿了一个十几岁女孩的语言模式,并从其他Twitter用户的互动中学到了东西。然而,当她开始分享纳粹言论和种族诽谤时,她成为最臭名昭著的AI错误之举之一。事实证明,巨魔已经使用AI的机器学习来对抗它,并充满了偏执的交互。

不久之后,微软就让Tay脱机了。

面部识别AI通常会因为各种错误原因而成为头条新闻,例如有关面部识别和隐私问题的故事。但是,这种AI在尝试识别有色人种时也引起了极大的担忧。

在2015年,用户发现Google相册将一些黑人归为大猩猩。 2018年,ACLU的研究表明,亚马逊的Rekognition人脸识别软件将28名美国国会议员确定为警察嫌疑人,误报不成比例地影响了有色人种。

另一起事件涉及苹果的Face ID软件错误。将两名不同的中国妇女确定为同一个人。因此,iPhone X所有者的同事可以解锁手机。

同时,麻省理工学院的研究员Joy Buolamwini回忆说,在进行面部识别技术时,经常需要戴上白色口罩才能使该软件识别她。 。为了解决这样的问题,Buolamwini和其他IT专业人员正在关注这个问题,以及对用于AI培训的更具包容性的数据集的需求。

虽然人们长期以来一直使用Photoshop来创建骗局图像,但是机器学习却采用了这种方法。达到新的水平。诸如FaceApp之类的软件可让您将主题从一个视频转换为另一视频。

但是许多人利用该软件进行各种恶意使用,包括将名人面孔添加到成人视频中或生成恶作剧视频。同时,互联网用户已经帮助改进了该技术,从而使其越来越难以区分真假视频。结果,这使得这种类型的AI在传播虚假新闻和恶作剧方面非常强大。

为展示技术的力量,导演Jordan Peele和BuzzFeed首席执行官Jonah Peretti制作了一个Deepfake视频,展示了似乎是美国前总统巴拉克·奥巴马(Barack Obama)借助Deepfake的力量提供了PSA。

Twitter机器人最初是为了自动执行诸如品牌客户服务回复之类的事情而创建的。但是现在,该技术是引起人们关注的主要原因。实际上,研究估计,Twitter上实际上有多达4800万用户是AI机器人。

许多机器人帐户不仅在模仿算法来跟踪某些主题标签或响应客户查询,还尝试模仿真实的人。然后,这些“人"会助长骗局,并使虚假新闻传播开来。

一波Twitter机器人甚至在一定程度上影响了英国脱欧和2016年美国总统大选的公众舆论。 Twitter本身承认,它发现了约50,000个有关选举的俄罗斯制造的机器人。

机器人继续困扰着该服务,传播了虚假信息。问题非常普遍,甚至甚至影响了公司的估值。

路透社报道,2018年10月,路透社报道说,在该软件的AI决定优先考虑男性应聘者之后,亚马逊不得不取消工作招聘工具。

希望保持匿名的员工挺身而出告诉路透社他们在该项目上的工作。开发人员希望AI根据其简历确定最佳职位候选人。但是,参与该项目的人很快注意到AI惩罚了女性候选人。他们解释说,人工智能使用了过去十年中的简历,其中大多数来自男性,作为其训练数据集。

因此,人工智能开始根据关键字“女性"过滤出简历。他们的关键字出现在CV的“女性象棋俱乐部队长"活动下。虽然开发人员更改了AI以防止对女性简历的这种惩罚,但亚马逊最终放弃了该项目。

YouTube儿童频道有许多愚蠢而异想天开的视频,旨在娱乐儿童。但这还存在一个垃圾视频,这些视频会操纵平台的算法。

这些视频是基于热门标签的。由于年幼的观众不是很挑剔,因此使用这些关键字的垃圾视频吸引了数百万的观看次数。 AI根据趋势标签使用库存动画元素自动生成其中一些视频。即使是由动画师制作的视频,其标题也是专门为关键字填充而生成的。

这些关键字可帮助操纵YouTube的算法,从而得到推荐。使用YouTube儿童应用程序的孩子的供稿中出现了大量不当内容。其中包括描述暴力,跳蚤和性内容的内容。

为什么机器学习会出错

机器学习导致意外后果的主要原因有两个:数据和人。在数据方面,适用“垃圾进,垃圾出"的口头禅。如果馈送到AI的数据是有限的,有偏差的或低质量的;结果是AI的范围或偏见受到限制。

但是,即使程序员正确地处理了数据,人们也可以在工作中费劲。软件的创建者通常不会意识到人们可能如何恶意使用该技术或出于自私的目的。 Deepfake源自用于改善电影院特殊效果的技术。

旨在提供更身临其境的娱乐的目的也最终会在被剥削时破坏人们的生活。

有人在努力改善电影的效果。围绕机器学习技术的防护措施,以防止恶意使用。但是技术已经存在。同时,许多公司并未表现出防止滥用这些开发成果的意愿。

机器学习算法可以帮助我们

当您意识到有多少机器学习和人工智能达不到预期。但这也从很多方面帮助我们-不仅在便利方面,而且在总体上改善了我们的生活。

标签: